Los modelos de IA «razonadores» elevan costes de evaluación hasta 5.200 dólares

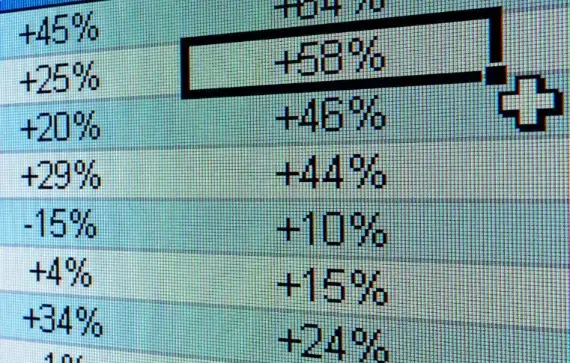

Analizar 12 modelos avanzados duplica el gasto frente a 80 convencionales. OpenAI y Anthropic lideran esta tendencia, donde pruebas como MMLU-Pro superan los 1.800 dólares por ejecución. La complejidad de los tests y el volumen de tokens generados explican el incremento.

«Verificar la IA ahora requiere un presupuesto»

Según Artificial Analysis, evaluar el modelo o1 de OpenAI en siete benchmarks costó 2.767,05 dólares, mientras que versiones no razonadoras como GPT-4o apenas alcanzaron los 108,85 dólares. George Cameron, cofundador de la firma, advierte: «Nuestro gasto mensual crecerá con cada nuevo lanzamiento».

¿Por qué son tan caros?

Los modelos generan ocho veces más tokens que sus predecesores. El o1 produjo 44 millones durante las pruebas, según datos de Artificial Analysis. Jean-Stanislas Denain, de Epoch AI, añade: «Los benchmarks actuales exigen tareas complejas, como ejecutar código o navegar por internet».

El dilema de la transparencia

Ross Taylor, CEO de General Reasoning, cuestiona la reproducibilidad: «Si los laboratorios gastan ‘y’ en computación, pero los académicos tienen recursos << y, ¿cómo validamos sus resultados?". Algunas empresas ofrecen acceso gratuito a sus modelos para evaluaciones, lo que genera dudas sobre la independencia de los tests.

De la física a la factura

OpenAI y Anthropic promueven modelos que resuelven problemas paso a paso en dominios como física o matemáticas. Sin embargo, su superioridad implica costes por token disparados: GPT-4.5 cobra 150 dólares por millón de tokens de salida, y el o1-pro de OpenAI, 600 dólares.

La ciencia bajo presión presupuestaria

El avance de la IA razonadora tensiona los recursos para validaciones independientes. Mientras los laboratorios privados escalan sus inversiones, académicos y pequeñas firmas enfrentan una brecha creciente en capacidad de verificación. El ritmo de innovación podría superar pronto los mecanismos de evaluación existentes.