Legislatura de California aprueba ley de seguridad en IA para su ratificación

Desarrollo de modelos avanzados de IA. La normativa obliga a las empresas tecnológicas a revelar sus protocolos de seguridad, en un contexto de creciente preocupación por los riesgos de esta tecnología.

Contenido de la normativa

La ley exige a las compañías de inteligencia artificial divulgar sus regímenes de pruebas de seguridad y certificar su cumplimiento. Se aplica a modelos «frontier» y establece requisitos diferenciados según el volumen de facturación anual de la empresa desarrolladora.

Apoyos y oposición

La medida ha recibido el apoyo de Anthropic, rival de OpenAI, y ha evitado la oposición frontal del año anterior. No obstante, grupos de presión del sector, como la Cámara de Comercio de California y TechNet, que representa a Apple, Amazon y Google, se oponen a la ley.

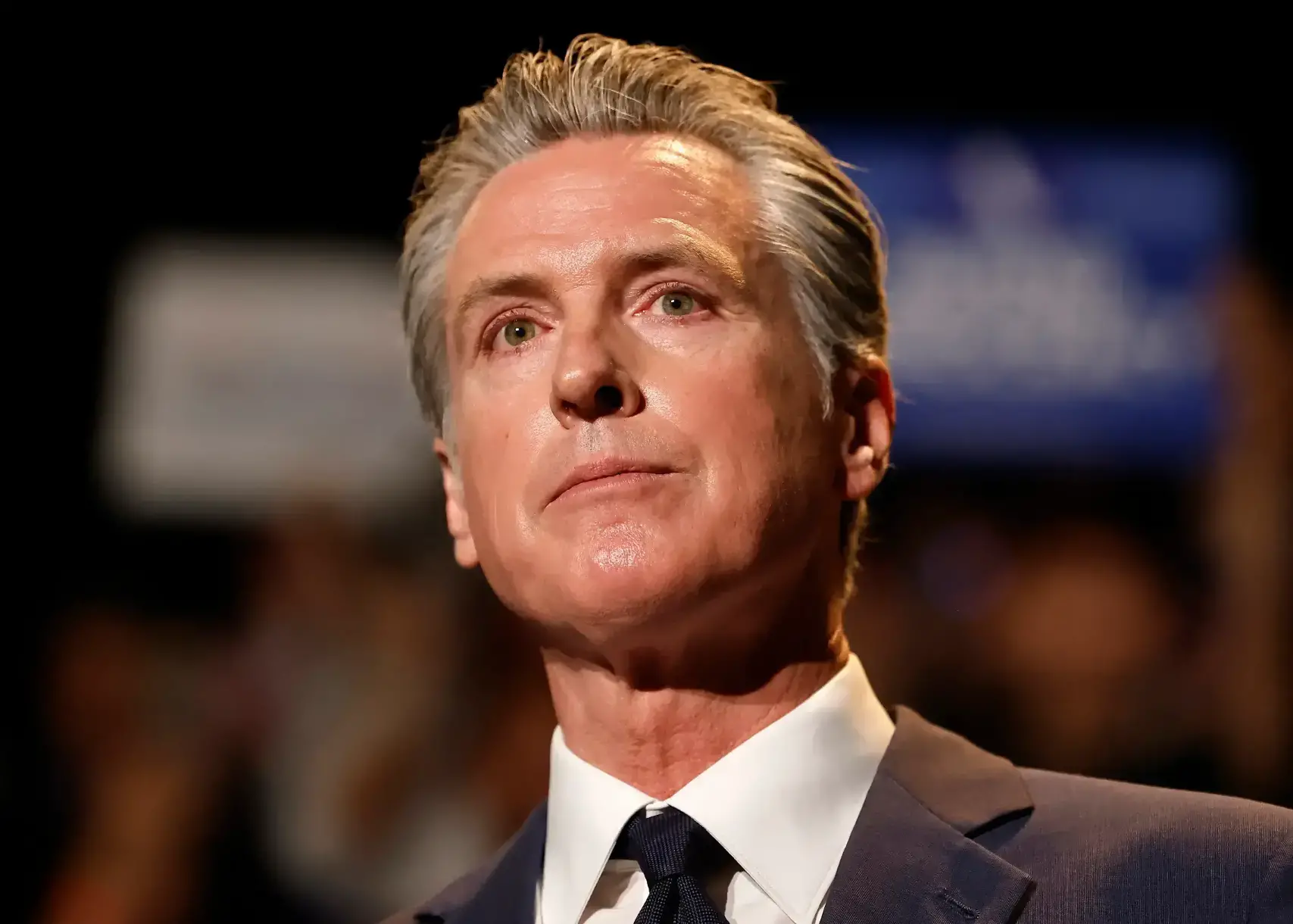

Un desafío político

El gobernador Gavin Newsom debe decidir si promulga la ley, lo que supone un equilibrio entre la industria tecnológica y las preocupaciones de los votantes. El año pasado vetó una propuesta similar por temor a dañar la innovación y la competitividad del estado.

Antecedentes

El senador estatal demócrata Scott Wiener presentó una ley similar el año pasado, que fue vetada por el gobernador Newsom. La propuesta actual está basada en un informe de expertos en seguridad de IA que el propio Newsom encargó tras su veto anterior.

Implicaciones

La decisión de Newsom podría sentar un precedente regulatorio a nivel nacional, dada la influencia de California en la industria tecnológica, y afectar a su proyección política de futuro.