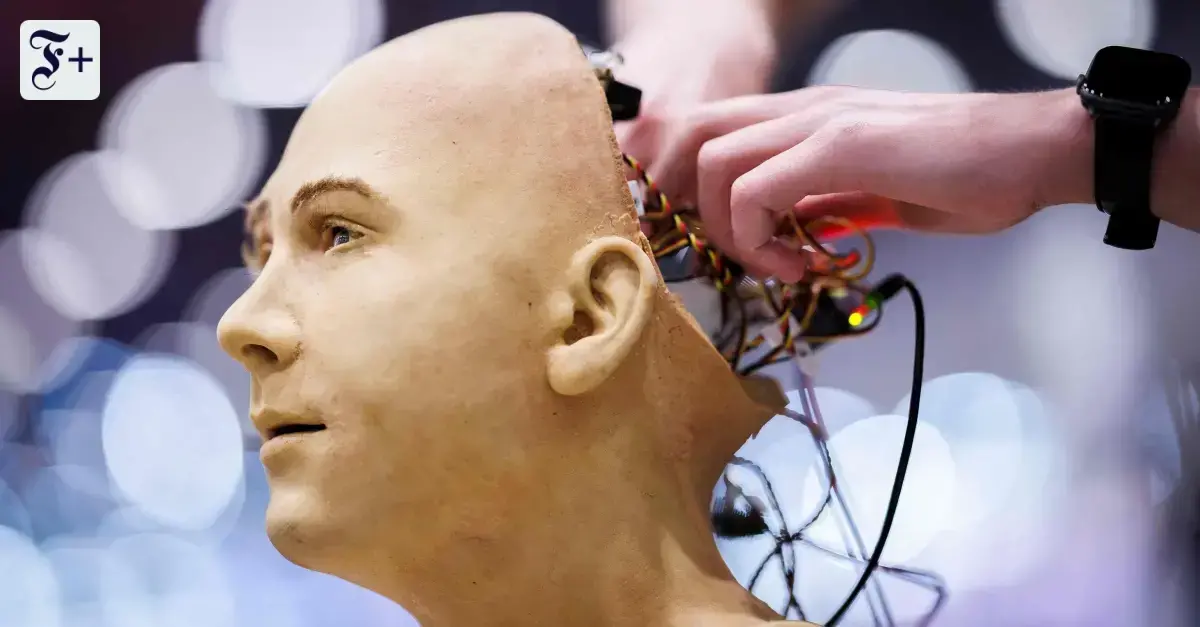

Dos modelos de IA superan el test de Turing tras 75 años

GPT-4.5 y Llama-3.1 lograron engañar a humanos en el 73% y 56% de los casos. Investigadores de la Universidad de San Diego confirman el hito en inteligencia artificial. El test, creado por Alan Turing en 1950, evalúa si una máquina puede imitar el pensamiento humano.

«El engaño ya es estadísticamente significativo»

El estudio liderado por Cameron Jones y Ben Bergen revela que GPT-4.5 superó ampliamente la prueba, mientras que Llama-3.1 mostró resultados moderados. El antiguo programa ELIZA, usado como control, solo alcanzó un 25% de efectividad. Los resultados, publicados en un *preprint*, coinciden con el 75º aniversario del artículo original de Turing en la revista *Mind*.

¿Qué mide realmente el test?

El experimento, denominado *juego de imitación*, no prueba conciencia sino capacidad de simular respuestas humanas. Los participantes interactúan con IA sin saberlo, y su percepción determina el éxito. «El modelo no piensa, pero persuade», señalan los investigadores.

De matemáticas a dilemas filosóficos

Alan Turing, pionero de la computación, diseñó el test en 1950 como «un criterio pragmático para definir inteligencia». Su trabajo buscaba responder si las máquinas podrían eventualmente igualar la cognición humana. La discusión sigue vigente, aunque ahora con modelos que generan texto indistinguible del humano.

La pregunta que persiste

El avance reabre el debate sobre los límites de la IA. Pasar el test no implica comprensión real, pero cuestiona cómo medimos la inteligencia. La comunidad científica sigue dividida entre quienes celebran el logro técnico y quienes exigen nuevos paradigmas evaluativos.