Reino Unido exige verificación de edad estricta para acceder a porno

Las plataformas enfrentan multas de hasta 18 millones de libras si incumplen. La medida, vigente desde el 25 de julio, aplica a webs y redes sociales. Ofcom supervisará siete métodos de validación para proteger a menores.

«Demasiado fácil para los niños acceder a contenido nocivo»

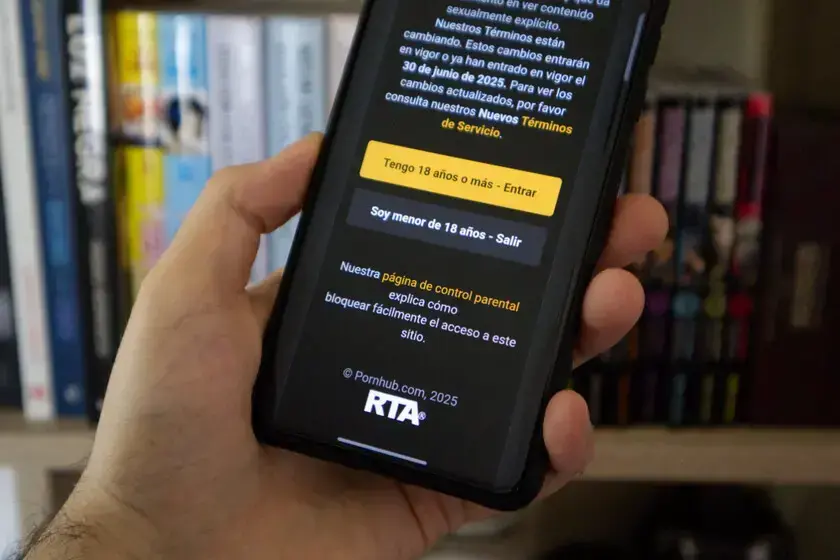

Según Ofcom, el 8% de menores de 8 a 14 años consume porno mensualmente, incluido un 3% de niños de 8-9 años. La Online Safety Act (2023) obliga a empresas a implementar sistemas «precisos y fiables». Plataformas como PornHub, Discord y X ya han adoptado medidas.

Métodos de verificación

Ofcom propone siete opciones: reconocimiento facial, verificación bancaria, tarjetas de crédito o eID. También sugiere cruzar datos de operadoras móviles o analizar la antigüedad de correos electrónicos. El uso de VPNs sigue siendo un vacío legal, dependiente del control parental.

Sanciones y alcance

Las multas pueden alcanzar el 10% de los ingresos globales de la empresa. Ofcom puede solicitar bloqueos judiciales a webs infractoras. La norma también afecta a contenido sobre suicidio o trastornos alimenticios en redes como TikTok o Instagram.

Una batalla con décadas de historia

La regulación del acceso a porno para menores es un debate global. Reino Unido sigue pasos similares a iniciativas europeas como el eIDAS2 o el «pajaporte» español. Ofcom ya evalúa algoritmos de redes sociales para evitar que menores reciban contenido perjudicial.

El desafío de proteger sin restringir

El éxito de la medida dependerá de su implementación técnica y de la cooperación entre plataformas, reguladores y familias. Mientras, otras jurisdicciones observan los resultados para replicar el modelo.